▲来源:ACM

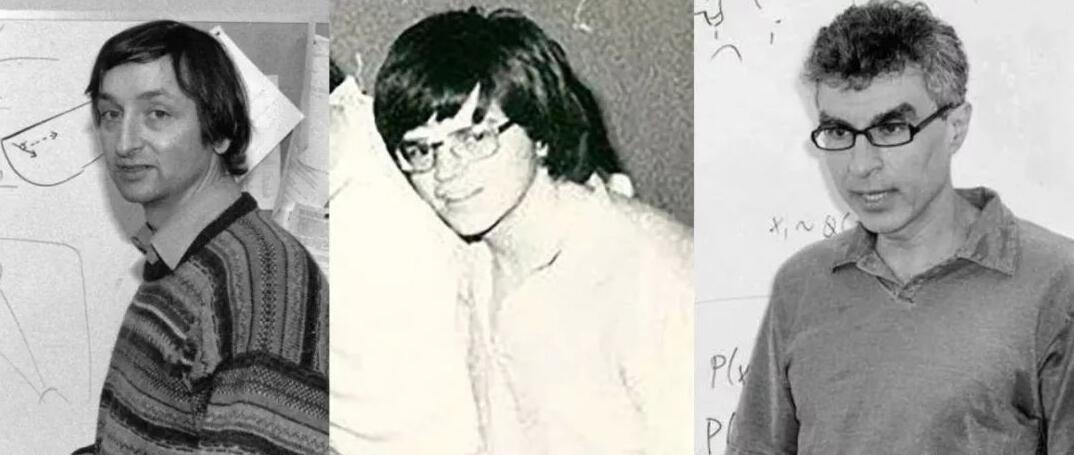

深度学习三巨头齐获图灵奖

有“计算机界诺贝尔奖”之称的 ACM AM图灵奖(ACM A.M. Turing Award)刚刚官宣,Yoshua Bengio、Geoffrey Hinton、Yann LeCun(中文名杨立昆)获得了2018年度图灵奖,表彰他们以概念和工程的突破,让深度神经网络成为计算关键部件。

图灵奖以已故英国著名数学家艾伦·图灵的名字命名,创立于1966年,是计算机界的最高荣誉,被誉为“计算机界的诺贝尔奖”,奖金为100万美元,由谷歌公司提供。

美国电子计算机协会的公告说,这三位科学家在概念和工程学上取得突破,使深度神经网络成为计算科学的关键部分。这种深度学习方法促使计算机视觉、语音识别、自然语言处理和机器人等领域取得突破性进展。

ACM这样介绍他们三人的成就:

Hinton、LeCun和Bengio三人为深度神经网络这一领域建立起了概念基础,通过实验揭示了神奇的现象,还贡献了足以展示深度神经网络实际进步的工程进展。

ACM主席Cherri M. Pancake评价说,人工智能是现在科学领域发展最快的领域之一,也是社会上最受关注的话题之一。人工智能的发展很大程度上归功于Bengio,Hinton和LeCun奠定基础的深度学习的新进展。

今日,AI 早超越了 “炒作” 的阶段,已经向全球及多个行业展现了实际的技术突破及应用能力,毫无疑问,这三位学者厥功至伟。

这三位人工智能界的大神级学者,都是在 80 年代前后投入深度神经网络的研究领域,在当时,这绝对是个冷门的领域。

但就同 Geoffrey 在过去接受媒体采访时所提到的,将他引上这条超过 40 年研究之路的不是别的,就是对 “人脑的好奇”。在过去接受彭博的一次访问中,Geoffrey Hinton 就曾提到, “如果你真的想了解一个非常复杂的装置,比如大脑,那你就自己造一个”,这样的一个念头,让他就此进入人工神经网络研究的世界。有同样的想法的不只 Geoffrey Hinton,Yann LeCun 也是如此。Yann LeCun 得知获得殊荣后,Facebook 博客也刊登了他的看法,Yann LeCun 指出,“我们三个人进入这个领域不仅仅是因为我们想要建造智能机器,我们只是想了解“智能”,包括“人类智能”,“我们正在寻找智能和学习的基本原则,并通过构建智能机器来了解我们自己”。

ACM 表示,这三位学者共同开发该领域的概念基础,并验证了令人惊艳的表现,为工程进展带来了贡献,证明了深度神经网络的实际优势。

近年来,深度学习方法在计算机视觉、语音识别、自然语言处理和机器人技术带来了惊人突破,其影响也已经蔓延到计算机以外太多其他领域,数学家物理学家化学家生物学家也都开始用深度学习加速科研。

Yoshua Bengio,1964年生,55岁,蒙特利尔大学计算机科学与运筹学系全职教授,也是深度学习“三巨头”中唯一一位仍全身心在学术界工作的大牛。他的诸多科研积累,包括深度学习架构、循环神经网络(RNN)、对抗算法、表征学习,影响和启发了后来的大量研究者,将深度学习应用到自然语言处理、计算机视觉等人工智能的各个主要领域,对近年来深度学习的崛起和发展起到了巨大的推动作用。目前,他是仅存的几个仍然全身心投入在学术界的深度学习教授之一,为人工智能培养了许多杰出的下一代人才。

Bengio创建了蒙特利尔学习算法研究所(MILA),担任研究所的科学主任,主持加拿大高等研究院(CIFAR)机器与大脑学习项目的研究。同时,Bengio也担任着数据评估研究所(IVADO)的科学联合主任。

ACM总结了Bengio的三个主要贡献:

序列的概率模型:

上世纪90年代,Bengio提出了序列的概率模型。他把神经网络和概率模型(例如隐马尔可夫模型)相结合,用新技术识别手写的支票。外界认为,这是20世纪90年代神经网络的巅峰之作,当下语音识别技术就是在它的基础上扩展的。

高维词汇嵌入和注意机制:

Bengio参与发表了一篇里程碑式的论文,A Neural Probabilistic Language Model(神经概率语言模型),把高维词嵌入 (High-Dimentional Word Embeddings) 作为词义的表征。这对NLP研究(如翻译、问答和视觉问答等任务)产生了深远的影响。

生成对抗网络(GAN):

2014年,Bengio与Ian Goodfellow一同发表的生成对抗网络 (GAN) ,引发了计算机视觉和图形学的革命。

据统计,Yoshua Bengio发表的300多篇学术文章的累计引用次数已经超过137000次。

作为教授,Bengio曾经和Ian Goodfellow、Aaron Courville等业界大神一起写出了Deep Learning,成为人手一本的“AI圣经”,不少人将这本书亲切称之为“花书”。

除了学术界,Bengio也活跃在产业界。

曾经,Bengio联合Jean-Franois Gagné创立了Element AI,为那些想给自家业务寻找机器学习解决方案的公司,找到AI领域的专家。

除此之外,Bengio也有许多荣誉在身。他不仅成为了加拿大皇家学院(RSC)及加拿大高等研究院(CIFAR)的院士,还在2017年获得了代表加拿大公民最高荣誉的“加拿大总督功勋奖”。

Geoffrey Hinton,1947年生,现年72岁。谷歌副总裁兼工程研究员,AI研究机构Vector Institute 的首席科学顾问,多伦多大学的名誉大学教授。他在80年代把以前没有受重视的反向传播(BP)算法引入了神经网络,使得复杂神经网络的训练成为可能,直到今天,反向传播算法依然是训练神经网络最重要的算法。之后,他又在1983 年发明玻尔兹曼机(Boltzmann Machines),以及在 2012 年改进了卷积神经网络的,并在著名的 ImageNet 评测中取得惊人成绩,在计算机视觉领域掀起一场革命。

在ACM颁奖辞博文中,主要提到了Hinton的三个贡献,如果你做过AI项目,肯定不会陌生,它们分别是:

反向传播(Backpropagation):

1986年,在Learning Internal Representations by Error Propagation这篇论文里,Hinton证明了,反向传播能让神经网络发现自己内部的数据表征,这样便可以处理以往无法解决的问题。

如今,反向传播已经是神经网络的标准操作,Hinton也有了“反向传播之父”的名号。

玻尔兹曼机(Boltzmann Machines):

1983年,Hinton和同伴一起发明了玻尔兹曼机,那是最早能够学习神经元内部表征的网络之一:那些表征既不来自输入,也不来自输出。

改进卷积神经网络:

2012年,Hinton和学生们一起,利用线性整流神经元(Rectified Linear Neurons)和dropout 正则化改进了卷积神经网络。

在ImageNet比赛上,他们几乎把物体识别的错误率降到了从前的一半,让计算机视觉领域焕然一新。

在获得图灵奖之前,Hinton就已经获得了大量的荣誉,手握加拿大最高荣誉勋章(Companion of the Order of Canada),是顶级认知科学奖鲁梅哈特奖的首位获奖者,也获得了人工智能国际联合会(IJCAI)杰出学者奖终生成就奖等等。

此外,他也是英国皇家学会成员、美国工程院外籍院士。

一个有趣的轶事是,Hinton的高祖父是大名鼎鼎的乔治·布尔——布尔逻辑的创立者,因“布尔检索“而闻名于世。

Yann LeCun,1960年生,58岁,Facebook人工智能研究院负责人,纽约大学数据科学中心的创始人之一。他最广为人知的工作是CNN(卷积神经网络)。Yann LeCun,将反向传播算法引入了CNN,并且发明了权值共享、池化等技巧,让CNN真正更为可用,现在,CNN已经广泛用于计算机视觉、语音识别、语音合成、图片合成以及自然语言处理等学术方向,以及自动驾驶、医学图片识别、语音助手、信息过滤等行业应用方向。他还在 1998 年开发了 LeNet5——首个被大规模商用的 CNN,并制作了被Hinton称为“机器学习界的果蝇”的经典数据集 MNIST 。更难能可贵的是,他坚持了约20年,才迎来了 CNN 如今的繁荣。

ACM列举的成就有:

卷积神经网络 (CNN) :

1989年,在AT&T贝尔实验室工作的LeCun,以反向传播为基础,发表了一项研究,叫做“将反向传播用到手写邮编的识别上”。CNN的第一次实现,就是在这里诞生。

如今,CNN已经成为深度学习的基础技术了,不止在计算机视觉领域,在语音合成、语音识别这些应用中,也是行业标准操作。

反向传播雏形:

1985年,Hinton还没有成为反向传播之父的时候,LeCun在巴黎六大读博期间,发表过反向传播的一个早期版本,根据变分原理给出了一个简单的推导过程。

他用两种加速学习的方法,让反向传播变得更快了。

拓展了神经网络的视野:

LeCun不止把神经网络用在图像识别上,还解锁了许多其他任务。他提出的一些概念,如今已经成了AI领域的基础。

比如,在图像识别上,他研究了神经网络怎样学习分层特征表示 (Hierarchical Feature Representation) ,这也成为了如今许多识别任务中常用的概念。

另外,他和同伴Léon Bottou一起提出,学习系统可以由复杂的神经网络构成。在这样的系统里,反向传播是靠自动微分来实现。他们还提出,深度学习架构可以对结构化数据 (比如图形) ,进行处理。

LeCun博士毕业后,只在Hinton的实验室做了一年博士后,就进入了工业界。

不过,他在2003年成为了纽约大学的教授,还在2012年创办了纽大数据科学中心。即便加入Facebook之后,也继续在纽大兼职。

AI 是当今科学界发展最快的领域之一,也是社会上最受关注的话题,”ACM 总裁 Cherri M. Pancake 说,“人工智能的成长及其带来的优点,很大程度上归功于深度学习的最新进展,而这些就是奠基于 Yoshua Bengio、Geoffrey Hinton 和 Yann LeCun 的研究,数十亿人使用这些技术,智能手机的用户可以体验自然语言处理和计算机视觉领域的进步,这在过去 10 年是不可能实现的,除了我们每天使用的产品之外,深度学习的新进展也为科学家提供了强大的新工具,从医学、天文学到材料科学等。

对于三位大牛获奖,AI 行业或科研圈的多数人都表示祝贺, “实至名归”、”众望所归”更是许多人乍听这个消息的第一反应。

DeepTech 采访了数位 AI 领域科研工作者,一位青年科学家表示,“三位可说众望所归,是对深度学习的历史地位的确认”,他进一步解释,过去机器学习在实务上有很好的性能表现,但理论上则有人认为缺乏坚实理论基础,但 ACM 将图灵奖授与三人,显示对他们贡献给予肯定。另一位科研工作者则指出,深度学习给计算机领域带来巨大的新突破,影响已经蔓延到计算机以外太多其他领域,如数学家、物理学家、化学家、生物学家,也都开始用深度学习加速科研,“这种影响力的迅速突破非常少见”。

Google 高级研究员兼 Google 高级研究员 Jeff Dean 也表示,“深度神经网络为现代计算机科学带来了大跃进,也帮助计算机视觉、语音识别和自然语言理解这些长期问题,取得实质进展,” Jeff Dean 说。“这些进步的核心是 30 多年前 Yoshua Bengio、Geoffrey Hinton 和Yann LeCun 开启的基本技术。通过大幅提高计算机理解世界的能力,深度神经网络不仅改变了计算领域,而且几乎改变了科学和人类努力的每一个领域。“

机器学习、神经网络和深度学习为何能独领风骚?

在传统计算中,计算机程序使用明确、逐步的指令来指导计算机,但在深度学习中,计算机并没有明确被告知该如何解决特定任务,如对象分类。相反地,它使用学习算法来提取数据中的模式(pattern),涉及数据的输入,例如图像的像素、标注、到输出。研究人员面临的挑战是开发有效的学习算法,能够修改人工神经网络中连接的权重,所以可抓取数据中的相关模式。

Geoffrey Hinton 从 80 年代早期就致力在 AI 领域倡导机器学习方法,研究人类大脑如何发挥作用,应将其应用在机器学习系统的开发。受到大脑的启发,他和其他人提出“人工神经网络”作为机器学习研究的基石。

在计算机科学中,“神经网络”是指由在计算机模拟“神经元”的一层一层组成的系统。这些“神经元”与人类大脑中的神经元相似,通过加权连接相互影响,并通过改变连接上的权重,可以改变神经网络执行的计算,三位大牛提出使用多层构建深层网络的重要性,因此也称为“深度学习”。

三位大牛 30 年努力所奠定的概念基础和工程进步,受惠于 GPU、计算机的普及以及对大量数据集而取得显著进展,Yann LeCun 在 Geoffrey Hinton 的指导下进行博士后工作,Yann LeCun 和 Yoshua Bengio 在 90 年代初都任职于贝尔实验室,尽管没有一起工作,他们的研究也激起了相互影响。

他们三人持续探索机器学习与神经科学和认知科学的交叉,特别是他们共同参与 CIFAR 的机器和大脑学习计划。

一小撮甘于坐冷板凳的“蠢货”

这一次 ACM 选择深度学习理论,在深度学习领域又选择了这三位先驱,有更深层的意义。因为,在深度学习和神经网络领域具有突出贡献的绝不止这三位学者,而他们并称为三巨头的原因,也并不只是因为他们投入研究的时间长达3、40年,更是因为他们始终保有对神经网络的兴趣,在他们的名字广为世人所知的几十年时间里,他们甘于用掉人生大部份的时间坐冷板凳做研究,才推动了神经网络走向复兴。

从上世纪50年代开始,神经网络的发展起起伏伏,被人唾弃过,也被屡次唱衰过。

多亏了一批最早在黑暗中等待黎明的人,不断研究探索,才有了人工智能的今天。这是一段卧薪尝胆般的故事,将Hinton、LeCun和Bengio的命运交织在一起。

三十多年以来,他们仨一直徘徊在人工智能研究的边缘地带。像局外人一样坚守着一个简单的观点:计算机可以像人类一样,通过神经网络思考,依靠直觉而不是规则。

而当时主流学术界给出的答案,是一个震耳欲聋的No。他们说计算机最佳的学习方式,就是规则和逻辑。Hinton主张的神经网络,被他们“证明”是错的。

1972年,25岁的Hinton在爱丁堡大学攻读博士学位,并把神经网络作为研究重点。导师几乎每周都会提醒他在浪费时间。然而Hinton不为所动。

1980年代LeCun在巴黎读大学时,计算机就是瞎子,无法识别图片中的内容,也无法判断摄像头前方出现了什么。但就在那个时候,LeCun偶然涉足了探索人工智能领域的一种方法:“智能神经网络”。

这并不是一条新路,而且并不受待见。但在攻读博士学位时,LeCun顶着一片质疑声专注于研究神经网络。“我只是不相信他们所说的。”他说。

1985年,Bengio在加拿大麦吉尔大学时,根本没人教神经网络。他学的是经典的、符号化的人工智能(Symbolic AI),所以,想做神经网络,必须先说服教授来指导他。

在上世纪80年代末,神经网络曾有过一次小小的复苏。但由于计算力和可用数据的缺乏,人工智能再次进入寒冬。一直到2000年代初期,这群坚信神经网络的学者处境愈发边缘化。一些学术机构甚至不允许他们在会议上发表论文。计算机视觉的圈子将他们拒之门外。

在蒙特利尔大学任教的Yoshua Bengio发现,他很难找到愿意与自己共事的研究生。“我需要强迫学生从事这方面的研究,他们害怕在博士毕业后找不到工作。”

对Hinton、Bengio和LeCun来说,这是一段黑暗的时期。

“当然,我们一直相信它,也一直在研究它。”Hinton说。

“神经网络终有一天会回来——至少有很小一撮人心里是这么想的。”LeCun说。

Hinton出生于一个学术背景显赫的世家。在他长大成人的过程中,母亲给过他两种选择:“做学者,或是做失败者。”7岁就已经意识到要读博的Hinton说,自己一辈子都在压抑、沮丧中挣扎。

但他投入研究的神经网络,真真是经历过漫长而幽暗的岁月。除了面对学术上的不认可,他的两任妻子先后罹患了癌症。而他自己也深受背痛困扰。

2003年,Hinton在多伦多,被CIFAR招揽过去启动一个神经计算项目。于是,他们聚到了一起,决定努力奋斗,重新点燃这个领域的热情。

一直到大约2009年前后,计算机最终有了足够的算力挖掘大型数据库,从此神经网络开始在语音和图像识别方面战胜基于逻辑的系统。工业界很快注意到变化的发生,微软、Facebook、谷歌等科技巨头开始在这个领域投资。

Bengio评价Hinton时说“他有时可以穿过黑暗看清事物。但他的个人生活非常不容易。他也有他的黑暗时代”。

在黑暗中穿行的日子里,他始终坚持一个信念:其他人都错了。

不过最终,他们都算是等到了春天。

在去年一次彭博社的采访中,Hinton说:未来是很难预测的。当你开始试图预测未来20年会发生什么事情,你基本就错得离谱了。但也有一些东西是可以预测的,比如人工智能技术将会改变一切。

在上世纪80 年代,人工神经网络被引入作为帮助计算机识别模式和模拟人类智能的工具,到 21 世纪初,专研此法的这三位学者仍是小众,虽然他们重新点燃 AI 社区对神经网络的兴趣,尽管一开始遭到怀疑,但随着算力的突破,他们的想法终于迎来技术大跃进,从学术界异类甚至是边缘成为主流范式。沉浮30年,深度学习终获最高认可。

据悉,三位获得此殊荣的学者将在 6 月 15 日于 ACM 年度颁奖宴会上正式获得 2018 年图灵奖。

编辑:顾军

责任编辑:樊丽萍

来源:综合自DeepTech深科技、量子位、新华社等